M4 : Apple va-t-elle se faire doubler par Intel, AMD et Qualcomm ?

Apple a surpris tout le monde1 avec la puce M1, un système sur puce aussi performant que frugal. Le résultat a été une sorte de séisme, et c’est peu de le dire, mais la période était surtout très propice pour Apple, avec une concurrence finalement assez faible. Mais depuis, il faut bien avouer que les évolutions ne suivent pas nécessairement : nous avons dû attendre un peu plus de 20 mois pour l’Apple M2, qui n’est pas une amélioration renversante et ensuite 16 mois pour l’Apple M3. Et même si les rumeurs indiquent que l’Apple M4 est prévu assez rapidement, les autres constructeurs ne se sont pas reposés sur leurs lauriers.

Le marché en 2020

Il faut commencer par la situation il y a un peu moins de quatre ans : Intel était dans la tourmente, AMD reprenait du poil de la bête et les puces ARM étaient très nettement derrière ce qu’Apple proposait. C’est Intel qui avait probablement le plus de soucis, et c’est ce qui explique d’ailleurs surement l’arrivée des puces ARM chez Apple et les gains très impressionnants sur certains appareils, comme le MacBook Air. À la fin de l’année 2020, Intel se débattait encore avec ses Core de 10e génération (Comet Lake) qui n’étaient que des Core de 6e génération (Skylake, 2015) poussés dans leurs derniers retranchements.

Ce n’est pas une exagération de notre part : Intel employait la même architecture depuis cinq ans en élevant la fréquence et en multipliant le nombre de cœurs au détriment de la consommation. Le Core i7 6700K, haut de gamme de la 6e génération, intégrait quatre cœurs à une fréquence maximale de 4,2 GHz avec une consommation moyenne de l’ordre de 65 W. Son pendant de 2020, le Core i9 10900K, contenait 10 cœurs, montait à 5,3 GHz et pouvait demander plus de 250 W en charge. Cette consommation élevée bridait largement les variantes mobiles, qui représentaient déjà le gros des ventes, et les propriétaires de MacBook Pro cuvée 2020 comprennent bien le problème. En pratique, l’autonomie était faible, les nuisances sonores importantes et les performances en demi-teinte dans un environnement contraint par la consommation.

Le second larron dans le monde x862 était dans une situation différente, mais pas nécessairement plus envieuse. AMD avait réussi à revenir dans la course en 2017 avec les premiers Ryzen (Zen) mais devait confirmer sa position. Au moment du lancement des puces Apple M1, AMD annonçait les Ryzen 5000 (Zen 3), qui offraient d’excellentes performances mais — à l’époque — se limitaient aux ordinateurs de bureau. Il a fallu attendre quelques mois pour voir débarquer les variantes mobiles qui allaient permettre à AMD de reprendre du poil de la bête dans un marché dominé par Intel, celui des PC portables.

Enfin, ARM restait à la traine à l’époque. Les meilleurs systèmes sur puce, comme le Snapdragon 865, intégraient généralement des cœurs Cortex A77 très largement en retrait par rapport aux cœurs d’Apple et personne n’imaginaient vraiment introduire ce type de cœurs dans des PC, à part quelques constructeurs qui s’en sont mordu les doigts, avec des PC portables ARM compliqués à vendre et aux performances bien trop faibles, même pour un usage léger. Voilà pourquoi Apple a réussi un coup de maitre : la marque est arrivée avec une puce plus performante et qui consommait moins que tout ce que la concurrence proposait, dans un contexte ou une réponse rapide était compliquée, sauf peut-être pour le challenger du x86, AMD.

Une question de processeur

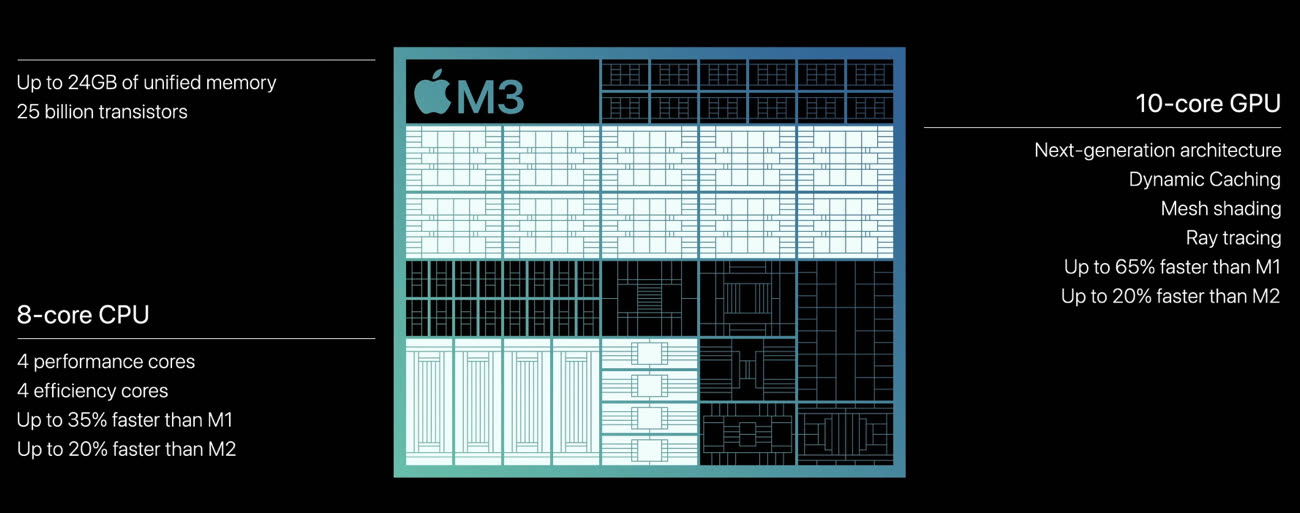

Commençons par la partie processeur. Dans les puces M actuelles, la structure n’a pas bougé depuis le M1 chez Apple, avec du 4+4, c’est-à-dire quatre cœurs performants et quatre cœurs basse consommation. Par contre, les résultats, eux, bougent : Apple a augmenté la fréquence et (un peu) les prestations brutes sur les cœurs performants. Sur les cœurs basse consommation, le gain est par ailleurs très net. Mais la concurrence, qui était à la rue à la sortie des premiers Mac M1, a réagi.

Chez Intel, pour commencer, tout a évolué. Après avoir trainé la même architecture pendant cinq ans, Intel a lancé plusieurs nouvelles générations depuis, jusqu’à la 15e qui abandonne la dénomination « Core i ». Sur les performances sur un seul cœur, utiles dans les tâches qui ne sont pas facilement parallélisées, les puces M restent compétitives : une puce M3 offre des résultats équivalents aux meilleurs Core i9 de 14e génération dans ce cas de figure.

@donatello

La frontière entre NPU et GPU est assez faible car pas mal de carte graphique peuvent tourner un genre de NPU notamment Nvidia.

Chez Apple, c’est différent. Mais c’est plus difficile à comprendre car c’est macOS qui gère les calculs et suivant ce qu’il y a besoin, ça va tourner sur différent partie du SoC. On le voit clairement avec le rétro-ingénierie qu’on effectuer Asahi. Il y a d’ailleurs des instructions AMX pour optimiser l’IA.

En tout cas, les puces Apple Sillicon sont très bonnes. Et pour les comparer avec d’autres personnes avec qui je travaille, elles sont largement au dessus au niveau portable.

Et même en développant, pas mal d’applications dans différents language de programmation, c’est plutôt la RAM qui manque qu’un problème de puissance de processeur. Avec 64 Go de RAM, j’ai pas trop de soucis mais d’autres avec 16 Go, c’est plus compliqué.

excellent article Pierre, bravo !!🎈🎊

Article très intéressant ….mais assez inquiétant pour Apple. En décidant de faire cavalier seul dans le domaine des processeurs ils n’ont pas le droit à l’erreur !

" Sommes-nous en train de dire qu’Apple va mourir et que les puces Apple Silicon vont perdre de leur superbe ?"

Apple est terminée, F I N I, terminée ! *court partout*

@oomu

Oui les oracles et les mayas l’avaient prévus depuis l’iPhone 6 d’ailleurs 😋

@cecile_aelita

Les mayas je ne sais pas, mais Apple est morte l’année prochaine était la phrase culte des années 90, bien avant l’iphone

https://www.macg.co/news/voir/220212/michael-dell-explique-sa-petite-phrase-de-1997

@oomu

Si Apple n’avait changé de proc, c’est possible. Si la concurrence redevient trop forte, il faudra encore changer …

Attention à Intel, après 3 générations à roupiller ils sont entrain de se réveiller et semblent enfin sortir de leur problème lié à la finesse de gravure en 10nm+ qui les a longtemps bridé et obligé à booster la consommation et le TDP pour tenir la dragée haute à la concurrence.

Cependant, avec l’adoption d’une toute nouvelle architecture et l’abandon de l’hyperthreading (une petite révolution), couplé à une finesse de gravure à la page et à l’introduction d’APU dédié à l’IA avec une volonté affirmée par Intel d’aller se faire une place dans ce domaine, je pense que les cartes peuvent être rebattues !

AMD n’est pas en reste, leur expertise en matière de circuits graphiques intégrés et leur avantage en matière de consommation/performance, en font un concurrent revenu sur le devant de la scène et redoutable.

Sans parler de Qualcom qui sur mobile fait désormais jeu égal avec un A17 Pro sur ces derniers Snapdragon !

Et ils ont pour avantage d’être couplé à davantage de Ram cadencée plus vite pour permettre à la partie CPU de bénéficier d’une meilleure bande passante et de donner son plein potentiel.

Si Intel et AMD ne se sont pas concentré comme Apple sur les APU c’est pour la bonne et simple raison qu’ils ne voient pas l’IA en local mais via internet et les calculs déportés sur serveurs.

Pourquoi gaspiller de la place sur un Die pour y coller un APU quand on sait que le client pourra faire sa requête Copilot ou Gemini depuis internet sur son PC portable ou de bureau ?

Apple veut absolument intégrer un modèle d’IA local de type Ferret, ce qui les oblige forcément à démultiplier la puissance de leur APU (pour des résultats moyens vu ce que les tests de l’IA locales des Pixel et de Galaxy S24 ont donné..).

C’est une approche qui peut faire sens sur mobile parce qu’on peut être amené à se déplacer et à être privé de tout réseau (ça devient rare quand même), et donc adieu la requête sur serveurs.

Par contre sur PC portable et PC de bureau, les situations dans lesquelles l’utilisateur se retrouverait totalement privé de réseau deviennent rarissime (même en cas de coupure internet on peut partager son réseau 5G).

Ça n’est pas demain la veille que des IA génératives locales seront suffisamment puissantes et compétentes pour assurer des tâches « lourdes » hors ligne, Apple devra démultiplier la puissance de ses APU si elle s’obstine dans ce sens, mais surtout elle devra drastiquement augmenter la dotation en RAM de ses iPhone et IPad, 8Go voire 12Go ça ne sera pas suffisant quand les meilleurs modèles actuels en demandent 14 ! Et vu la pingrerie d’Apple sur la RAM on va bien rigoler.

De toutes façons tout cela est logique, chez Apple il n’y a pas des magiciens et des ingénieurs ayant 10 ans d’avance, tôt ou tard la concurrence allait décortiquer les choix d’Apple et faire siennes les pistes les plus intéressantes, on met du temps à le voir venir parce qu’il y a une grosse inertie chez Intel et AMD qui ont des plans sur plus de 5 ans !

Dans 5 ans justement je suis prêt à parier que l’avance d’Apple se sera totalement effacée notamment dans les ordinateurs portables.

Enfin n’oublions pas qu’on compare deux choses qu’on ne compare pas normalement :

- De l’ARM

- Du X86

Le X86 a beaucoup plus de jeux d’instructions à gérer que l’ARM et son potentiel est tout autre, l’ARM est plus « flexible » et « léger ».

La vraie surprise ce serait qu’un acteur du marché arrive avec une architecture qui ne soit ni ARM, ni X86 et parvienne à concilier le meilleur des deux mondes, parce que la bataille entre ces deux philosophies ne date pas d’hier.

« les autres constructeurs ne se sont pas reposés sur leurs lauriers »

Forcément, puisqu’à l’époque les lauriers ne leurs revenaient pas, Apple les raflait 😂

« les concurrents d’Apple remontent très vite la pente quand Apple tend tout de même à se reposer sur ses lauriers après le séisme provoqué par les puces M1 en 2020 ». Si Apple ne leur avait pas soufflé au cul, ils ne seraient pas montés « si » haut. Qui c'est qui dormait sur ses lauriers ? Ben jusqu'à 2020… les autres.

Alalalàa ce bon vieux réflexe du Mac contre le pc et du qui à la plus grosse. Je suis en train de changer des ordinateurs de mon parc et mes employés, qui sont tous absolument nul en informatique/multimedia, me donne leurs doléances chaque jour. Absolument aucuns ne m’a parlé de puissance processeur. Jamais.

Nous sommes arrivés à un moment où la puissance processeur n’a plus vraiment de sens (pour le commun des mortels). Par contre, la question de l’autonomie revient absolument sans arrêt. Et l’utilisateur lambda se moque d’attendre 3 minutes de plus, tant que pendant ces trois minutes, la machine fonctionne.

D’ailleurs, il suffit de regarder les ventes d’Apple.

Et ça s’explique assez facilement. Les pc ont fortement progressé en terme de prix. Le bas de gamme avec les celerion, N100 ou N200 sont des machines anémiques et avec une autonomie très moyenne et dès que l’on veut avoir un pc correct, nous sommes tout de suite dans les 700€. Du coup, la frontière pour attraper le MacBook Air est faible et Apple engrange les millions. Parce que l’argument premier reste l’autonomie. Et c’est bien pour cela qu’Apple ne se presse absolument pas pour changer quoi que ce soit. La course à la puissance n’a aucun sens. Par contre celle de l’autonomie ancrée dans l’esprit des gens par les téléphones portables, lui a tout son sens. Mais bon, c’est une logique compliquée pour ceux qui ont vécu le powerPC contre le pentium.

Sur l’IA, il me semble que ce n’est pas qu’une question de puissance, mais aussi d’absence de support simple des jeux d’instructions les plus utilisés par les librairies disponibles (CUDA)

Le vrai bénéfice pour moi d’une consommation faible c’est d’abord l’absence de bruit de ventilos. Je suis même surpris que les possesseurs de PC acceptent ça.

@hugome

C’est sur que c’est très appréciable.

Après le fait aussi de n’avoir que des produits à faible consommation chez soi (je ne parle pas que d’informatique) c’est aussi intéressant économiquement.

Exemple tout simple, j’ai acheté une maison récemment où vivaient des personnes âgées dedans … j’ai compté … il y avait 46 ampoules (ou spot) … toutes en filaments ou halogènes (dont 2 gros spots extérieurs de 400w chacun).

J’avais fais le calcul, ça représentait une consommation (si elles tournaient toutes évidement … ce qui n’est jamais le cas évidement …) de 3950W environ…

J’ai remplacé tout par des LED et les spots externes par des spots solaires pour une utilisation similaire (voir même plus de lumière dans certains pièces …), je suis maintenant à une consommation (toujours théorique évidement …) de 365w….

En gros divisé par 10!

Alors évidement qu’on va me dire que l’éclairage c’est pas la plus grande source de dépense en électricité … mais c’est surtout pour le principe en fait 🙂. Me dire que j’avais 4kW juste d’éclairage … c’est à peine moins la puissance théorique de mon installation de chauffage dans toute ma maison 🙂.

@cecile_aelita

J’ai beaucoup de Macs à la maison, Ce n’est pas grand-chose à côté du lave-linge du lave-vaisselle de la tondeuse à gazon du chauffage ….

@melaure

Évidement, mais je préfère le voir comme quelque chose de global. Pour reprendre mon exemple d’éclairage … évidement que 10 ampoules de 75w, c’est rien à côté d’un lave linge… mais me dire que cumulé ça représente la moitié de mon lave linge …. Juste pour de l’éclairage 🫤… c’est ballot.

Mais j’ai conscience que tout le monde ne voudra pas faire cet effort. Mais autre exemple, avant on regardait la tv en couple dans le canapé … 190w/h la TV… maintenant on se met tranquillou dans le lit sur l’iPad (qui doit consommer 6-7w/h?). Et au final… ça nous convient très bien 🙂. Mais je ne demande pas aux autres de le faire. Je dis juste que NOUS, ca nous va 🙂↔️.

L’article néglige un aspect très important lors de comparaison : l’usage.

Autant sur des valeurs marketing et/ou de bench intel / amd et consort peuvent passer devant, autant dans l’usage quand il faut monter une vidéo ou faire des retouche les puces Apple Silicone sont là.

Et à mon sens cela vient du travail d’optimisation réalisé par Apple et les devs sur les applications.

Or sur la partie x86 le code n’est pas tout le temps optimisé et les développeurs peuvent se reposer sur la puissance brute des machines pour compenser…

« Mais depuis, il faut bien avouer que les évolutions ne suivent pas nécessairement : nous avons dû attendre un peu plus de 20 mois pour l’Apple M2, qui n’est pas une amélioration renversante et ensuite 16 mois pour l’Apple M3 »

On est à un peu moins de 4 ans depuis l’apparition de Apple Silicon sur Mac et bientôt à la génération m4… Au contraire on est dans les temps et les évolutions suivent assez régulièrement !

Dans un autre article, un de vos journalistes se plaignait qu’Apple ne ralentissait pas la cadence (comme si c était le cas ses concurrents…)…

Pages